یکی از بخش های ترسناک و ناشناخته سئو برای سئوکارهای تازه کار و وبمستران، آشنایی و کار با فایل robots.txt است. البته با توجه به اینکه نام آن کمی متفاوت بوده و محتوای نامتعارفی هم دارد، این ترس کاملا توجیه شده است. امروز میخواهم به ساده ترین شکل ممکن به شما توضیح بدهم که فایل robots.txt چیست؟ چه کاربردی در سئو سایت دارد و اصلا چطور باید یک فایل روبوت برای سایت بسازیم و آن را اعتبار سنجی کنیم. در انتهای این مقاله هیچ چیز ناشناخته ای در مورد این فایل در ذهن شما وجود ندارد. (اگر هم وجود داشته باشد به آن در بخش نظرات پاسخ میدهم!)

فایل robots.txt چیست؟

فایل robots.txt یک استاندارد مورد استفاده توسط وب سایت ها برای ارتباط با خزنده ها و سایر ربات های وب است. این یک فایل متن ساده است که به ربات های وب می گوید کدام صفحات وب سایت نباید خزیده شوند.

کاربرد robots.txt چیست؟

فایل robots.txt سایت یک راهکار برای برقراری ارتباط با ربات های موتور جستجو است. شما به کمک این فایل که در هاست سایتتان قرار گرفته و البته متنی که درون آن نوشته شده، میتوانید به ربات های خزنده موتور جستجو فرمان بدهید. ربات های موتورهای جستجو به صورت خودکار برای بررسی صفحات سایتتان، به سراغتان خواهند آمد و تمامی صفحات را ایندکس میکنند. (منظور از ایندکس این است که صفحات وب سایت را بررسی کرده و برای نمایش در نتایج جستجو طبق اصول سئو آماده میکنند.)

حالا ممکن است شما در این بین نخواهید که بعضی از صفحات سایتتان توسط این ربات ها ایندکس شوند. اینجاست که میتوانید به کمک یک خط کد در فایل روبات سایت به آنها بگویید که کدام صفحه یا صفحات را ایندکس نکنند.

چرا ربات های خزنده نباید برخی صفحات سایت ما را مشاهده کنند؟

اول از همه باید این نکته مهم را به توضیح بدهم که: اگر قرار باشد ربات های خزنده گوگل تمامی صفحات وب سایت شما را بررسی نکنند، این یعنی سایت شما اصلا در نتایج جستجو مشاهده نخواهد شد. به این شکل سئو (seo) برای سایتتان هیچ ارزشی ندارد.

اول از همه باید این نکته مهم را به توضیح بدهم که: اگر قرار باشد ربات های خزنده گوگل تمامی صفحات وب سایت شما را بررسی نکنند، این یعنی سایت شما اصلا در نتایج جستجو مشاهده نخواهد شد. به این شکل سئو (seo) برای سایتتان هیچ ارزشی ندارد.

در اصل کاری که ما قرار است انجام بدهیم، این است که به ربات ها بگوییم برخی از صفحات سایت ما را مشاهده و بررسی نکنند. هدفمان هم از این کار افزایش و بهبود سئو کلی سایت است. اما چه زمان هایی به کمک فایل روبوتس، صفحات سایت را از دید ربات های خزنده موتورهای جستجو پنهان میکنیم؟

1. در ابتدای طراحی سایت

اصولا زمانی که وب سایت خودمان را طراحی کرده باشیم، به کمک فایل robots کل وب سایت را از دید موتور جستجو پنهان میکنیم. دلیل این موضوع چیست؟ دلیل این است که در ابتدای ساخت سایت، قالب های وردپرسی اغلب یک سری صفحات آماده را روی وب سایتمان بارگذاری میکنند.

ما با پنهان کردن کل سایت از دید گوگل در ابتدای کار، به خودمان فرصت میدهیم تا صفحات اضافی سایت را حذف کرده و بقیه تغییرات لازم را روی آن ایجاد کنیم. در صورتی که این صفحات پیش فرض قالب در سایت ما ایندکس شوند، گوگل از همان ابتدا به دلیل وجود یک سری مطلب تکراری، اعتبار سئو سایتمان را کاهش میدهد. در نهایت و بعد از اینکه فعالیت های لازم برای طراحی بقیه برگه ها و حذف برگه های اضافی انجام شد، سایت را برای ربات ها قابل بررسی خواهیم کرد.

2. پنهان کردن صفحات غیر ضروری بعد از طراحی سایت

بعد از اینکه وب سایت ما به طور کامل طراحی و آماده نمایش به گوگل شد، باز هم ما با فایل robots سایت کار داریم. در سایت، برخی از صفحات وجود دارند که به صورت پیشفرض وجودشان ضروری است اما نمایش آنها در نتایج هیچ سودی ندارد.

بعد از اینکه وب سایت ما به طور کامل طراحی و آماده نمایش به گوگل شد، باز هم ما با فایل robots سایت کار داریم. در سایت، برخی از صفحات وجود دارند که به صورت پیشفرض وجودشان ضروری است اما نمایش آنها در نتایج هیچ سودی ندارد.

مثلا صفحه پرداخت سایت یا صفحه ورود به پنل کاربری سایت و… . اینها صفحاتی هستند که الزاما باید در وب سایت ما وجود داشته باشند اما به هیچ عنوان نیاز نداریم در نتایج ایندکس شوند. همینطور باید یادمان باید که ایندکس شدن این صفحات به دلیل مطالب کمی که درون خود دارند، باعث کاهش قدرت سئو کل سایت میشود. بنابراین بار دیگر سراغ فایل روبوتس سایت رفته و با کمک کدهایی که درون آن مینویسیم، این صفحات را هم از دید ربات موتور جستجو پنهان میکنیم.

3. حذف محتوایی خاص از ایندکس گوگل

گاها ممکن است ما قصد داشته باشیم که محتوایی خاص را از دید ایندکس گوگل پنهان کنیم. مثلا امکان دارد یک صفحه برای کمپین فروش بهاری در سایت ساخته باشیم و پس از اتمام بهار، بخواهیم آن را از ایندکس خارج کنیم. همینطور ممکن است بخواهیم ویدیوها و تصاویر سایت در ایندکس گوگل دیده نشوند. در این حالت ها باز هم به سراغ robots میرویم.

4. پنهان کردن صفحات بی ارزش، زامبی، تکراری و…

از robots سایت برای پنهان کردن صفحات بی ارزش، تکراری و… استفاده میکنیم. اما کدام صفحات؟ به عنوان مثال ممکن است در میان مقالات وب سایتمان، مقاله ای قدیمی وجود داشته باشد که کمتر از 300 کلمه متن دارد. این مقالات که به زامبی پیج معروفند، باعث کاهش ارزش سئو سایت میشوند. علاوه بر این ممکن است برای انجام یک سری کارهای تحقیقاتی مثل تست های انسانی، مجبور شویم که از یک صفحه سایت، دو یا چند صفحه مشابه داشته باشیم. در این حالت برای اینکه از طرف گوگل به داشتن محتوای duplicate و تکراری متهم نشویم، باید یکی از آنها را نگه داشته و بقیه را از دید موتور جستجو پنهان کنیم.

این موضوع برای صفحات تکراری دیگر هم قابل اجراست. مثلا زمانی که قصد داریم برای یک صفحه از مقالات سایتمان، یک صفحه pdf و یک صفحه قابل پرینت هم ایجاد کنیم، باید صفحه اصلی را نگه داشته و مابقی را به کمک robots.txt پنهان کنیم.

نکته: در سایت های وردپرسی برای اینکه صفحه ای سایت یا کل صفحات آن را از دید گوگل و بقیه موتورهای جستجو پنهان کنیم، میتوانیم به جای ایجاد تغییرات مستقیم در فایل robots، از افزونه هایی مثل رنک مث سئو یا یوآست سئو کمک بگیریم که رابط کاربری بسیار آسانی دارند. (در انتهای مقاله توضیح بیشتری میدهم.)

نکته 2: دقت کنید که همیشه هم نمیتوانیم به این اعتماد کنیم که ربات ها تمامی فرمان های داخل فایل روبوتس سایت را اجرا میکنند. گاها دیده شده که برخی ربات ها بی توجه به این دستورات، صفحات سایت را ایندکس کرده اند.

نکته 3: علاوه بر فایل robots، راهکار دیگر جهت پنهان کردن صفحات سایت از دید خزنده ها، کمک گرفتن از کد noindex است. این کد در بخش کدهای html هر صفحه از سایت (بین دو تگ باز و بسته head) قرار گرفته و به ربات ها دستور ایندکس نکردن صفحه را میدهد.

آموزش ساخت فایل robots.txt سایت

خب، تا اینجا متوجه شدیم که فایل robots.txt چیست، چه کاربردی دارد و چه زمانی باید از آن استفاده کنیم. حالا باید به سراغ آموزش ساخت robots سایت برویم. در ادامه اول از همه یاد میگیریم که چطور وجود داشتن و نداشتن این فایل در سایت را بررسی کنیم. بعد از آن به سراغ این سوال میرویم که اگر robots در سایت ما وجود نداشته باشد چه اتفاقی می افتد و در نهایت بعد از آشنا شدن با کدهای robots.txt نحوه ساخت آن را آموزش میبینیم.

بررسی وجود فایل robots در سایت

اگر سیستم شما وردپرسی باشد، در حالت پیش فرض فایل robots سایت شما ساخته شده و در این آدرس قرار میگیرد:

example.ir/robots.txt

کافی است به جای example.ir آدرس دقیق وب سایت خودتان را قرار دهید. به عنوان نمونه میتوانید فایل robots.txt فرین آکادمی را مشاهده کنید:

/farin.academy/robots.txt

اگر بعد از وارد کردن این آدرس در مرورگر با یک صفحه 404 روبرو شدید، باید خودتان اقدام به ساخت robots سایت کنید. همینطور اگر صفحه ای خالی را مشاهده کردید، نیاز دارید فایل robots سایت را در هاست خودتان پیدا کرده و آن را ویرایش کنید.

اما یک سوال:

آیا وجود نداشتن فایل robots در سایت باعث کاهش سئو میشود؟

ربات های خزنده در صورت مشاهده نکردن فایل ربات، به صورت آزادانه به همه جای سایت سرک میکشند و همه صفحات آن را ایندکس میکنند. این یعنی عدم وجود فایل robots در سایت باعث کاهش مستقیم سئو سایت شما نمیشود. اما اگر صفحاتی که قرار است به کمک این فایل از دید ربات موتور جستجو پنهان شوند را پنهان نکنید، سئو وب سایتتان را کاهش میدهید.

ربات های خزنده در صورت مشاهده نکردن فایل ربات، به صورت آزادانه به همه جای سایت سرک میکشند و همه صفحات آن را ایندکس میکنند. این یعنی عدم وجود فایل robots در سایت باعث کاهش مستقیم سئو سایت شما نمیشود. اما اگر صفحاتی که قرار است به کمک این فایل از دید ربات موتور جستجو پنهان شوند را پنهان نکنید، سئو وب سایتتان را کاهش میدهید.

مثلا وجود صفحات کم ارزش، کم محتوا و تکراری به صورت مستقیم رتبه سایت را کاهش میدهد. همینطور وجود تعداد زیادی صفحات بی ارزش در سایت شما باعث میشوند که بودجه خزشی که گوگل برایتان در نظر گرفته کاهش پیدا کرده و سرعت ایندکستان کم شود. اما بودجه خزش چیست؟

بودجه خزش (Crawl Budget): گوگل برای بررسی و ایندکس وب سایت ها یک بودجه خزش در نظر میگیرد که نسبت به تازگی محتوای سایت، کیفیت و تعداد انتشار محتوا تعیین میشود. در صورت کاهش بودجه خزش، صفحات سایتتان با سرعت کمتری در صفحات نتایج جستجو ظاهر خواهند شد. برای اطلاعات بیشتر به مقاله افزایش سرعت ایندکس سایت مراجعه کنید.

دستورات ساخت فایل robots سایت

فایل robots.txt معمولاً در دایرکتوری اصلی یک وب سایت قرار دارد. به عنوان مثال، می توانید آن را در www.example.com/robots.txt پیدا کنید.

هدف اولیه آن کنترل خزیدن رباتهای وب است. این به جلوگیری از بارگذاری بیش از حد سایت با درخواست ها کمک می کند و برخی از قسمت های سایت را خصوصی نگه می دارد.

فرمت: فرمت robots.txt بسیار ساده است. از خط “User-agent” برای مشخص کردن اینکه دستورالعمل ها برای کدام ربات اعمال می شود، استفاده می کند و سپس خطوط “Disallow” یا “Allow” را برای مشخص کردن اینکه کدام مسیرها غیرمجاز هستند، استفاده می کند. به عنوان مثال:

*:User-agent

/Disallow: /private

/Allow: /public

این مثال به تمام رباتها دستور میدهد که هیچ صفحهای را در دایرکتوری “/private/” خزنده نکنند.

توضیح هر دستور برای ساخت فایل ربات سایت

دستور user-agent: این دستور برای تعیین نوع ربات های خزنده استفاده میشود. در سطح وب ربات های مختلفی به وب سایت شما سر میزنند. ربات های خزنده موتور جستجو بینگ، گوگل، یاهو و… اگر بخواهید نوع خاصی از ربات ها را برای دستورات خود فراخوانی کنید، باید در مقابل این کد نام آن را بنویسید. مثلا:

user-agent: googlebot

این تکه کد صرفا ربات های گوگل را فراخوانی میکند. اگر به جای نام ربات، علامت * را قرار دهید، در اصل روی صحبت شما با همه ربات ها است:

user-agent: *

دستور disallow: این همان دستوری است که به کمکش میتوانید تعیین کنید کدام صفحات از دید ربات ها پنهان باشند. مثلا:

disallow: /

به معنای این است که تمامی صفحات از ایندکس پنهان باشند.

disallow: /images

به معنای این است که پوشه images سایت غیر قابل ایندکس باشد. (دقت کنید که اگر در هاستتان نام پوشه عکس ها همین باشد، آنها پنهان میشوند. اگر نه باید نام دقیق آن را وارد کنید.)

/disallow: /seo

این به معنای پنهان کردن صفحه farin.academy/seo از دید ربات هاست.

دقت کنید که دستور disallow باید در خط بعد از user-agent قرار بگیرد. این یعنی در ابتدا باید ربات های مورد نظر را فراخوانی کنید سپس به آنها دستور ایندکس کردن یا نکردن صفحات را بدهید.

دستور Allow: این دستور بعد از دستور disallow قرار میگیرد. کاربرد آن این است که به ربات ها بگویید فلان فایل یا صفحه را از میان همه صفحاتی که قبلا دستور ایندکس نشدنش را داده بودید، ایندکس کنید.

مثلا در دستور قبلی گفتیم که تمامی عکس های درون پوشه images از دید ربات ها پنهان باشند. اما به کمک این دستور میتوانیم یک عکس خاص از این پوشه را برای ایندکس آماده کنیم:

Allow: images/seo.jpg

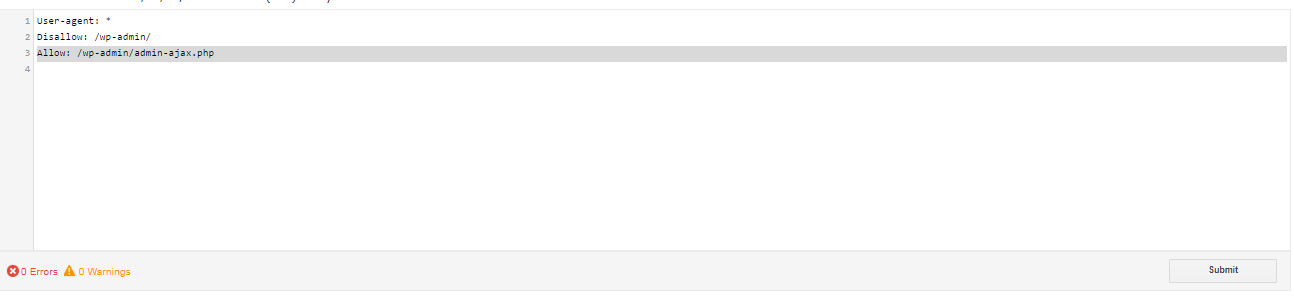

تست فایل robots.txt

گوگل قابلیتی در اختیار وبمستران گذاشته تا بتوانند فایل روبوت سایت خودشان را به کمک ابزار سرچ کنسول تست کنند. اگر قبلا سایت خودتان را در این ابزار ثبت کرده اید، کافی است به این آدرس رفته و بعد از انتخاب سایت، اخطارها و خطاهای موجود در مورد فایل روبوتس را مشاهده کنید. به عنوان نمونه تصویر پایین را مشاهده کنید:

طبق این تصویر، گوگل هیچ اخطار و اروری برای این فایل ثبت نکرده.

طبق این تصویر، گوگل هیچ اخطار و اروری برای این فایل ثبت نکرده.

کلام آخر

robots.txt راهی برای مدیران وبسایتها است تا نحوه تعامل موتورهای جستجو و سایر خزندههای وب با وبسایتهای خود را هدایت کنند. این بخشی از حوزه بزرگتر مدیریت وبسایت و استراتژیهای سئو است.

برخی از سوالات رایج

فایل robots.txt چیست؟

فایل robots سایت، یک فایل متنی بسیار ساده با فرمت txt است که شما میتوانید نمونه آن را همین حالا روی صفحه رایانه خودتان بسازید.

فایل robots.txt چه کاربردی دارد ؟

فایل robots.txt سایت یک راهکار برای برقراری ارتباط با ربات های موتور جستجو است. شما به کمک این فایل که در هاست سایتتان قرار گرفته و البته متنی که درون آن نوشته شده، میتوانید به ربات های خزنده موتور جستجو فرمان بدهید.

9 پاسخ

سلام.من نفهمیدم robots.txt اسم فایله یا robot.tx ??? مممنون میشم راهنمایی بفرمایید

سلام مهدی جان

robot.txt

سلام

نیاز هست فایل robot.txt رو در سرچ کنسول ثبت کنیم؟

اگر نیاز هست چه جوری میشه ؟

من با خوندن این متن متوجه نشدم

سلام خیر نیاز نیست و هیچ بخشی هم مربوط به این قضیه ندیدم

سلام نگارش مطلب عالی بود و ب خوبی متوجه شدم ممنونم ازتون به خاطر این دقیق نویسی و اهمیت به مخاطبه تازه کار

ی سوالی داشتم اینکه طبق این تفاسیر توی سایت فروشگاهی ما باید صفحاتی مثل سبدخرید و تسویه حسابو تشکر از خرید و مشابه اینارو نو ایندکس کنیم ؟؟؟ و وسط مقاله گفتید اخر مقاله در مورد استفاده از افزونه هایی مثل یوآست برای اینکار توضیح میدید که ندادید، الان میتونم با همون ویژگی افزونه یوآست تک تک صفحاتی که گفتمو نو ایندکس کنم و کار دیگه ای نیاز نیست ؟

و یک سوال دیگ اینکه اگر صفحه ای مثل درباره ما یا تماس با مارو نو ایندکس کنم و بعد افزونه اسکیما رو نصب کنم و نمایش دسته بندی ها زیر یوآر ال اصلی سایت رو فعال کنم ، چون قبلا این صفحات رو نو اندکس کردم اونارو برای اسکیما هم نشون نمیده ؟

سلام حسین جان

خوشحالم راضی بودی

بله قطعا باید نو ایندکس کنی

بله میتونی با یواست نوایندکس کنی

نشون میده برای اسکیما ولی خوب دیگه فایده ای ندارن چون نو ایندکس هستن

درباره ما، تماس با ما و صفحه اصلی حتی در صورت نداشتن کلمه کلیدی هم توصیه میکنم بذاری ایندکس بمونه

سلام جناب هاشمی

ممنون از مطلب فوق. اما سوال:

به فرض اینکه یک سایت با کد نویسی اختصاصی داریم. در فایل ربات ققید می کنیم:

user-agent: *

disallow: /cgi-bin/

disallow: /dashboard

disallow: /order-history

disallow: /wishlist

disallow: /address

disallow: /cart/*

مشخصا این قسمت: disallow: /cgi-bin/

به این معناست که ربات وارد اون بخش اختصاصی ادمین پنل نشه و اونارو ایندکس نکنه؟ یا نه اشتباه می کنم و این ممکن باعث بلوکه کردن ربات بشه؟

سلام بهتاش جان

من مشکلی توی فایل رباتت نمیبینم

با سلام و خسته نباشید , ممنون از مقاله کاربردی تون یک سوالی از خدمت شما داشتم قالب سایت من یک سری url پارامتر با # می سازه و حالا من میخوام کلیه url هایی که دارای # هستند رو از طریق فایل robots.txt از کراول شدنشون جلوگیری کنم . من این دستور رو (disallow: /*#*) داخل فایل robots قرار دادم , میخواستم بدونم با این دستور ایا همه ی url های دارای # کراول نمیشوند. میشه در این مورد راهنماییم کنید.